A Alfresco Software, Inc. anunciou hoje que está sendo adquirida pela empresa de private equity Thomas H. Lee Partners (Conhecida pela sigla “THL”).

A Alfresco Software, Inc. anunciou hoje que está sendo adquirida pela empresa de private equity Thomas H. Lee Partners (Conhecida pela sigla “THL”).

Do que se trata?

As empresas de “private equity” são investidores – eles compram empresas com a intenção expressa de vender essa empresa no futuro para obter lucro. Isso é muito diferente do que se a Alfresco tivesse sido adquirida por uma empresa de tecnologia maior ou concorrente no espaço ECM ou se tivesse arrecadado fundos através de um IPO.

Quase certo ?

A transação está sujeita às condições habituais de fechamento e às aprovações regulatórias e deverá fechar no primeiro trimestre de 2018. Os termos da transação não foram divulgados.

O que diz o Presidente da Alfresco ?

“Estamos entusiasmados com a oportunidade de se associar à THL – uma empresa com um histórico impressionante de empresas de serviços de informação e tecnologia de sucesso bem sucedidas”

disse Doug Dennerline, diretor-presidente da Alfresco.

“Com a experiência profunda da indústria da THL, experiência operacional e orientação estratégica, estaremos bem posicionados para expandir nossa plataforma, construir nosso espaço nos mercados de gerenciamento de conteúdo corporativo e automação de processos de negócios e continuar oferecendo aos clientes o melhor da classe serviço que eles conheceram e esperam”

E a versão Community ?

Está e uma grande dúvida, a custo prazo não devemos ter nenhuma mudança! A Alfresco chegou a onde chegou por causa de estratégia Open Source, e abandonar agora não seria uma boa opção, na verdade seria um erro, porém temos de aguardar as cenas dos próximos capítulos! Ainda está muito recente e provavelmente haverão nos próximos dias novas manifestações, .

O que faço para garantir uma versão Community e Open Source ?

Inicialmente eu diria , faça código! Se a Alfresco tomar qualquer ação para ser totalmente “Cloused Software” estaremos prontos para um fork ( não é uma ameaça, e sim uma realidade )! no momento eu me juntei a Comunidade “Order of the Bee” !

Não tenho acompanhado como anda a Comunidade (http://orderofthebee.org/ ) mas algo me diz que teremos novos integrantes por estes dias , que compactuam com todas as ideologias desta comunidade de Hackers em Alfresco!

O que acham de AlfBee ECM e ActBee BPM ? não .. não … ainda são somente pensamentos vazios! eu acredito na Alfresco e no poder do Open Source para as corporações, estaremos juntos! …juntos com os fontes… 😉

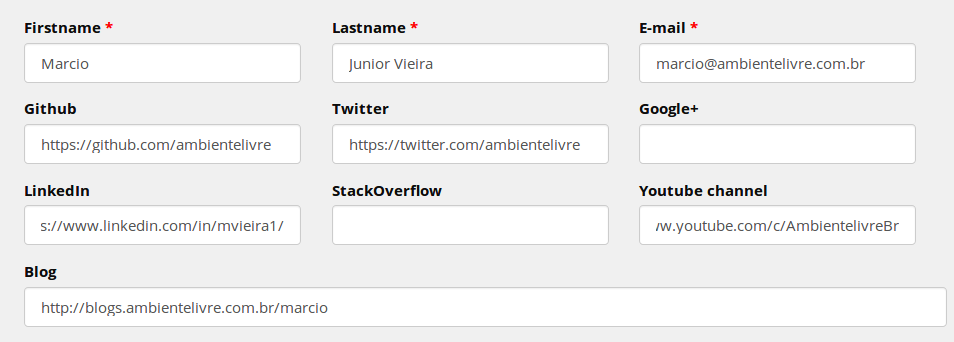

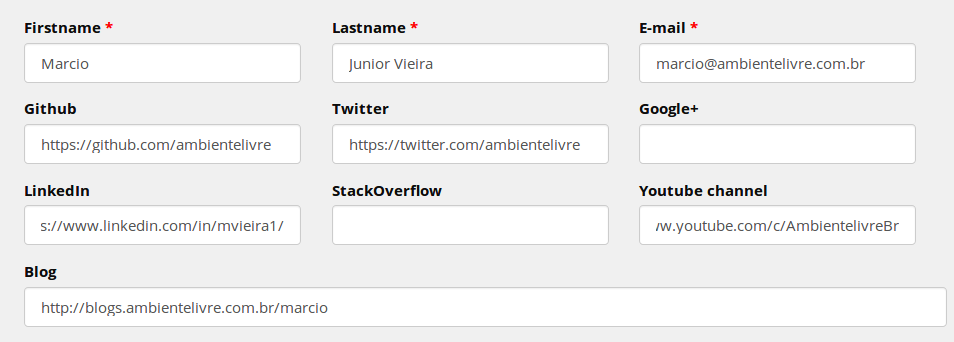

Eu acabei de me cadastrar e mandei os resumos abaixo:

Descrevam suas colaborações a Comunidade Alfresco e vamos fazer parte !!

Summary

I am a software developer, lecturer, teacher and trainer of open source technologies and free software, I use alfresco for approximately 10 years, minister training and lectures on Alfresco and Activiti, besides providing services and consultancy especially in the community version. I made some small code bundles to the project with plugins and translations.

What have you done for Alfresco and its community?

Articles and information about Alfresco in

http://blogs.ambientelivre.com.br/marcio/category/alfresco/

Plugins and Integrations Open Source Software:

https://github.com/ambientelivre/Alfresco-DataDictionary-pt_BR

https://github.com/ambientelivre/multi-authentication

https://github.com/ambientelivre/ThemeSugarAlfresco

Lectures at technology events

https://pt.slideshare.net/ambientelivre/alfresco-ecm-e-gesto-eletrnica-de-documentos-open-source

http://blogs.ambientelivre.com.br/marcio/palestra-sobre-o-cmf-drupal-integrado-ao-ecm-alfresco-por-cmis/

https://www.slideshare.net/ambientelivre/integrando-o-drupal-com-o-ecm-alfresco-usando-cmis

Sobre a Alfresco Software, Inc.

A Alfresco Software, Inc. (“Alfresco”) é uma empresa de softwares de código aberto dedicada ao avanço do fluxo de negócios digitais. A empresa oferece uma maneira melhor e mais fácil para as pessoas trabalhar, certificando-se de que eles têm a informação de que precisam, exatamente quando elas mais precisam. A Alfresco Digital Business Platform é usada para digitalizar processos, gerenciar conteúdo e gerenciar informações de forma segura. A Alfresco ajuda mais de 1.300 organizações líderes do setor, incluindo Cisco, Bank of NY Mellon, Liberty Mutual, Capital One, US Department of Navy e NASA, sejam mais receptivos e competitivos. Fundada em 2005, Alfresco tem sede nos Estados Unidos em San Mateo, Califórnia, e sede européia em Maidenhead, no Reino Unido. Para obter mais informações sobre a Alfresco, visite http://www.alfresco.com .

Sobre Thomas H. Lee Partners, LP

Thomas H. Lee Partners, LP (“THL”) é uma empresa de private equity de primeira linha que investe em empresas de crescimento médio do mercado, sediadas na América do Norte, exclusivamente em quatro setores da indústria: Business & Financial Services, Consumer & Retail, Healthcare e Media, Serviços de informação e tecnologia. Usando o conhecimento de domínio profundo da empresa e as capacidades operacionais internas do seu Strategic Resource Group, a THL procura criar vantagens de oferta de negócios e acelerar o crescimento e melhorar as operações em suas empresas de portfólio em parceria com equipes de gerenciamento. Desde a sua fundação em 1974, a THL arrecadou mais de US $ 22 bilhões em capital próprio, adquiriu mais de 140 empresas de portfólio e completou mais de 360 aquisições complementares que coletivamente representam um valor combinado da empresa no momento da aquisição de mais de US $ 200 bilhões.

Fontes:

Alfresco Acquired by Private Equity Firm – https://ecmarchitect.com/archives/2018/02/08/4324

Thomas H. Lee Partners to Acquire Alfresco Software https://finance.yahoo.com/news/thomas-h-lee-partners-acquire-160000078.html

Thomas H. Lee Partners to Acquire Alfresco Software – https://www.businesswire.com/news/home/20180208005437/en/

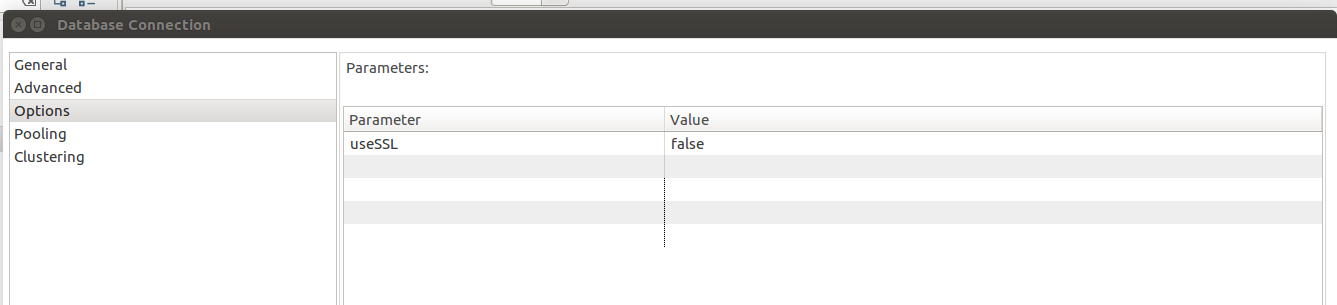

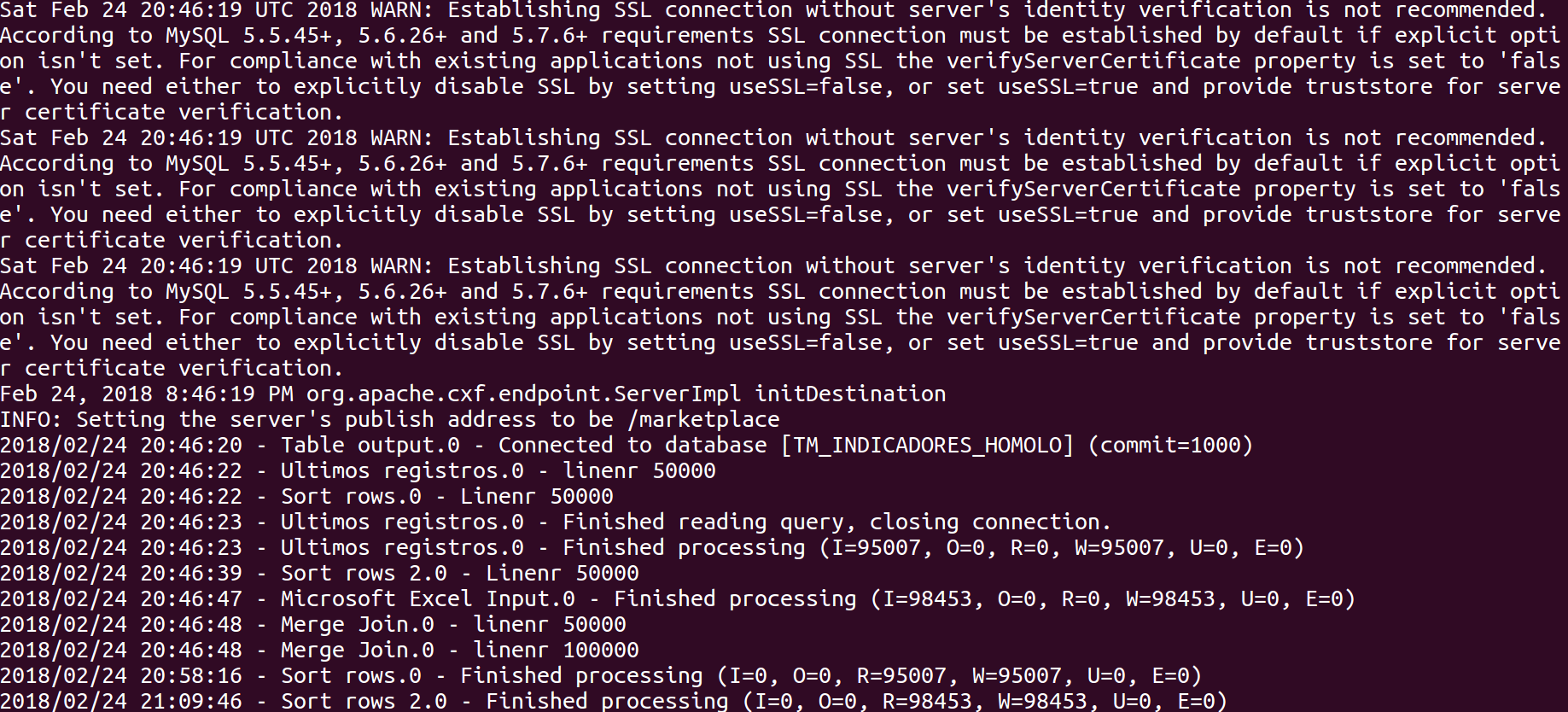

Em algum projetos que temos trabalhado com o RDS da Amazon ( que nada mais é o serviço baseado no Banco de Dados MySQL ) com Driver MySQL 5.1.40, recebíamos alerta de conexão quando não usávamos certificados SSL nas conexões JDBC do Pentaho Data Integration.

Em algum projetos que temos trabalhado com o RDS da Amazon ( que nada mais é o serviço baseado no Banco de Dados MySQL ) com Driver MySQL 5.1.40, recebíamos alerta de conexão quando não usávamos certificados SSL nas conexões JDBC do Pentaho Data Integration.